– Kubernetes, Docker Swarm und OpenShift im Vergleich

Container-Technologien haben in den letzten Jahren enorm an Popularität gewonnen und sind aus modernen IT-Infrastrukturen kaum noch wegzudenken. Durch ihren leichten und standardisierten Aufbau ermöglichen sie dir eine schnelle Bereitstellung und Ausführung von Anwendungen – sei es in einer Entwicklungs-, Test- oder Produktionsumgebung.

Doch mit wachsender Anzahl an Containern und steigender Komplexität der Umgebungen werden auch die Anforderungen an eine effiziente Verwaltung größer. Genau hier setzt die Container-Orchestrierung an. Zu den bekanntesten Plattformen zählen Kubernetes, Docker Swarm und OpenShift.

In diesem Artikel gehen wir tiefgreifend auf die Grundlagen dieser Plattformen ein, beleuchten gängige Skalierungs- und Deployment-Strategien und zeigen dir die konkreten Vorteile in agilen Umgebungen auf.

Was ist Container-Orchestrierung?

Unter Container-Orchestrierung versteht man die automatisierte Verwaltung mehrerer Container, die in verteilten Umgebungen laufen. Dazu gehören das Bereitstellen, Skalieren, Verteilen, Überwachen und Updaten von Containern.

Die Herausforderung besteht nicht nur darin, Anwendungen performant und stabil in Containern auszuführen, sondern auch in der richtigen Platzierung und Verwaltung auf mehreren Knoten (Servern oder virtuellen Maschinen). Eine Orchestrierungsplattform hilft dir dabei, Ressourcen effizient zu nutzen, Ausfälle automatisch zu kompensieren (Self-Healing) und Updates ohne signifikante Ausfallzeiten durchzuführen.

Wichtige Orchestrierungsplattformen

1. Kubernetes (K8s)

Kubernetes ist eine Open-Source-Plattform, die ursprünglich von Google entwickelt und 2014 freigegeben wurde. Es gilt heute als De-facto-Standard für Container-Orchestrierung und bietet Funktionen, die insbesondere in großskaligen Produktionsumgebungen essenziell sind.

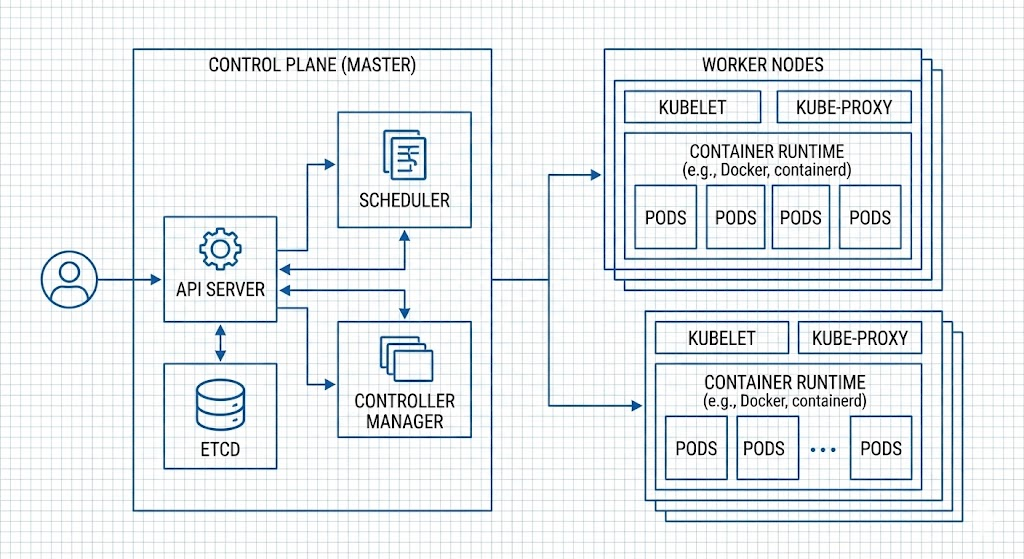

- Architektur: Kubernetes arbeitet mit einer Control Plane (früher Master-Node), die die Kontrolle übernimmt, und mehreren Worker-Nodes, die die Container ausführen. Auf der Control Plane laufen Komponenten wie der API-Server, die etcd-Datenbank, Controller und Scheduler. Worker-Nodes beherbergen die Container und verwalten diese über den Kubelet-Agenten.

- Objekte: Kubernetes verwendet verschiedene API-Objekte wie Pods, Services, Deployments und ConfigMaps, um eine granulare Steuerung zu ermöglichen. Ein Pod ist dabei die kleinste Verwaltungseinheit und kapselt einen oder mehrere eng verbundene Container.

- Vorteile: Hohe Flexibilität, riesige Community, mächtige Schnittstellen (z. B. für Helm-Charts) und ein stetiges Wachstum des Ökosystems. Self-Healing-Mechanismen starten Pods bei Ausfällen automatisch neu oder verteilen sie auf gesunde Nodes.

2. Docker Swarm

Docker Swarm ist die native Orchestrierungs-Lösung von Docker. Sie ist oft einfacher zu konfigurieren als Kubernetes, bietet dafür aber einen reduzierten Funktionsumfang.

- Architektur: Swarm basiert auf Manager-Nodes und Worker-Nodes. Die Manager kommunizieren über ein Consensus-Verfahren (Raft-Protokoll), um den Cluster-Zustand synchron zu halten.

- Stärken: Die nahtlose Integration in die Docker-CLI ist der größte Pluspunkt. Wer

docker runkennt, findet sich hier sofort zurecht. Für kleinere Setups oft völlig ausreichend. - Einschränkungen: Bei komplexen Netzwerkanforderungen, Multi-Cluster-Management oder granularen Sicherheitsrichtlinien stoßen Teams hier schneller an Grenzen als bei Kubernetes.

3. OpenShift

OpenShift ist die Container-Plattform von Red Hat, die im Kern auf Kubernetes aufbaut, diesen aber um Enterprise-Features erweitert.

- Architektur: Da OpenShift auf Kubernetes basiert, nutzt es dieselben Konzepte (Pods, Deployments). Es fügt jedoch eine integrierte CI/CD-Pipeline, eine eigene Image-Registry und „Source-to-Image“ (S2I) Workflows hinzu.

- Enterprise-Fokus: OpenShift liefert Sicherheit „out of the box“, z. B. durch strenge rollenbasierte Zugriffssteuerungen (RBAC) und Security Context Constraints (SCC).

- Nachteil: Die Komplexität und die Lizenzkosten (für die Enterprise-Version) sind höher. Mit OKD gibt es jedoch eine freie Community-Variante.

Skalierungs- und Deployment-Strategien

Eine der Hauptaufgaben der Orchestrierung ist das intelligente Management von Last und Updates.

Horizontale und vertikale Skalierung

- Horizontale Skalierung (Scale Out): Hierbei fügst du weitere Instanzen (Pods/Container) derselben Anwendung hinzu. Das ist der bevorzugte Weg in der Container-Welt.

- Vertikale Skalierung (Scale Up): Du weist dem einzelnen Container mehr CPU oder RAM zu. Dies ist durch die physische Hardware des Nodes limitiert und erfordert oft einen Neustart des Pods.

Deployment-Modelle

Um Updates ohne Downtime einzuspielen, bieten sich verschiedene Strategien an:

- Blue-Green-Deployment: Es existieren zwei fast identische Umgebungen. „Blue“ ist live, „Green“ ist die neue Version. Sobald Green getestet ist, schaltet der Loadbalancer den Traffic zu 100% um. Dies ermöglicht einen extrem schnellen Rollback.

- Rolling Updates: Der Standard in Kubernetes. Schritt für Schritt werden alte Pods durch neue ersetzt. Die Anwendung bleibt durchgehend verfügbar, da immer nur ein kleiner Teil der Instanzen gleichzeitig aktualisiert wird.

- Canary Releases: Die neue Version wird nur einem kleinen Prozentsatz der Nutzer (z. B. 5%) zur Verfügung gestellt. So kannst du Fehler in der Produktion erkennen, bevor alle User betroffen sind. Läuft alles stabil, wird der Traffic-Anteil sukzessive erhöht.

Vorteile in agilen Umgebungen

Warum lohnt sich der Aufwand der Orchestrierung für dich und dein Team?

- Schnelle Iteration: Agile Modelle (DevOps) leben von kurzen Zyklen. Orchestrierung automatisiert das Deployment, sodass neue Features mittels Rolling Updates oder Canary Releases fast risikofrei und kontinuierlich ausgeliefert werden können.

- Skalierbarkeit und Flexibilität: Egal ob Black Friday oder unerwarteter Traffic-Spike: Die Plattform skaliert dynamisch. Du nutzt nur die Infrastruktur, die du wirklich brauchst (Cost Efficiency).

- Effizienz durch CI/CD: Die Plattformen sind das perfekte Ziel für CI/CD-Pipelines. Self-Healing reduziert manuelle Eingriffe („Feuerlöschen“) im Betrieb drastisch.

- Höhere Zuverlässigkeit: Fällt ein Node aus, zieht die Workload automatisch um. Deine Anwendung bleibt verfügbar, ohne dass du nachts aufstehen musst.

Entscheidungsfaktoren für die richtige Plattform

Die Wahl zwischen Kubernetes, Docker Swarm und OpenShift hängt von deinen spezifischen Projektanforderungen ab:

| Kriterium | Kubernetes | Docker Swarm | OpenShift |

| Komplexität | Hoch (steile Lernkurve) | Niedrig (einfacher Einstieg) | Hoch (aber viele Hilfsmittel) |

| Flexibilität | Extrem hoch | Mittel | Hoch (mit Konventionen) |

| Ops-Aufwand | Hoch (außer Managed K8s) | Gering | Mittel (Red Hat Support) |

| Kosten | Open Source (frei) | Open Source (frei) | Lizenzkosten (Enterprise) |

- Wähle Docker Swarm für kleine, überschaubare Projekte, bei denen Einfachheit vor Feature-Reichtum geht.

- Wähle Kubernetes, wenn du maximale Flexibilität, Industriestandards und Skalierbarkeit für komplexe Anwendungen benötigst.

- Wähle OpenShift, wenn du eine „Rundum-sorglos“-Plattform für Enterprise-Umgebungen suchst und Support benötigst.

Fazit und Ausblick

Container-Orchestrierung ist der Motor moderner IT-Infrastrukturen. Während Docker Swarm mit Einfachheit punktet, ist Kubernetes der unangefochtene Standard für komplexe Umgebungen. OpenShift ergänzt diesen Stack um wertvolle Enterprise-Funktionen.

In agilen Teams, in denen Flexibilität und Stabilität zählen, ist der Einsatz einer solchen Plattform fast unumgänglich. Wer die Transformation wagt und sich in die Konzepte von Pods, Services und Deployments einarbeitet, legt den Grundstein für eine zukunftssichere IT-Landschaft.

| Quelle | URL |

|---|---|

| Kubernetes Documentation | https://kubernetes.io/docs/ |

| Docker Dokumentation (inkl. Swarm) | https://docs.docker.com/ |

| Red Hat OpenShift Docs | https://docs.openshift.com/ |

| OKD – Open Source-Variante von OpenShift | https://www.okd.io/ |

| Container Journal – Artikel zu Orchestrierung | https://containerjournal.com/ |

| CNCF (Cloud Native Computing Foundation) | https://www.cncf.io/ |

This post is also available in:

Deutsch