Nachdem wir uns im ersten Teil mit dem grundlegenden Dashboard befasst haben (Datenschutz in Copilot), geht es nun ans Eingemachte: Die Copilot Einstellungen. Während die Übersicht uns zeigt, wer Copilot nutzt, legen wir hier fest, wie die KI mit Daten umgeht und wo die Grenzen deines Tenants verlaufen.

Für IT-Administratoren ist dieser Bereich das wichtigste Werkzeug, um die Balance zwischen maximaler KI-Produktivität und strengen europäischen Datenschutzvorgaben zu halten. In diesem Artikel schauen wir uns an, wie du die EU Data Boundary optimal nutzt, den Zugriff auf das Web steuerst und die Anbindung externer Agents sicher verwaltest.

– Benutzerzugriff

Im Reiter Benutzerzugriff steuerst du, wie Copilot in verschiedenen Schnittstellen deines Unternehmens erscheint und wer Zugriff auf spezielle Vorschau-Funktionen erhält. Hier legst du fest, ob Benutzer eigenständig Lizenzen erwerben können und wie tief die KI in die Administrator-Oberflächen integriert wird.

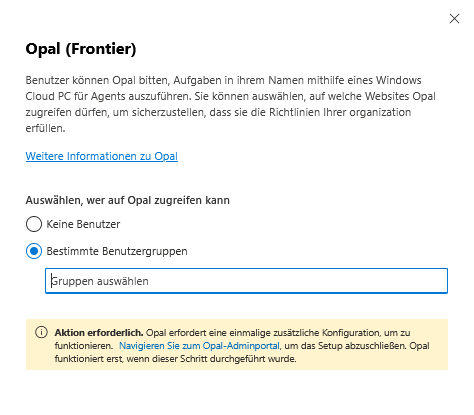

Opal (Frontier)

Diese Funktion ermöglicht es ausgewählten Benutzern, die experimentelle KI-Unterstützung von Opal innerhalb von Microsoft 365 Copilot zu nutzen.

- Erweiterte Agent-Funktion: Benutzer können Opal beauftragen, Aufgaben in ihrem Namen auszuführen, wobei die KI einen dedizierten Windows Cloud PC für Agents nutzt.

- Compliance-Steuerung: Administratoren können hier auswählen, auf welche Websites Opal zugreifen darf. Dies ist entscheidend, um sicherzustellen, dass die KI-Aktionen strikt den internen Richtlinien und Sicherheitsvorgaben der Organisation entsprechen.

- Einmaliges Setup: Damit Opal funktionsfähig ist, muss eine einmalige Konfiguration im spezifischen Opal-Adminportal durchgeführt werden. Hierbei ist sicherzustellen, dass die verantwortlichen Administratoren einer entsprechenden Admin-Gruppe zugewiesen sind.

Empfehlung: Aufgrund des experimentellen Charakters und des Website-Zugriffs sollten Admins die Berechtigungen zunächst nur für eine Pilotgruppe freischalten und die Interaktionen kritisch prüfen.

Nur im Frontier Early Access-Programm mit Microsoft 365 Copilot-Lizenz verfügbar!

👉 Zur offiziellen Dokumentation: https://go.microsoft.com/fwlink/?linkid=2339568

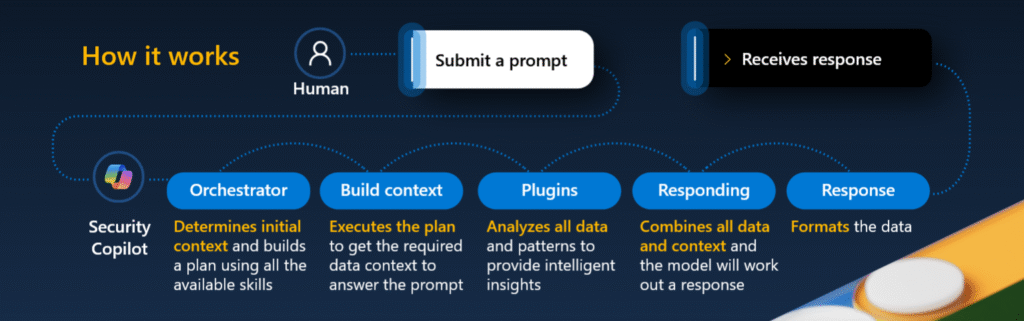

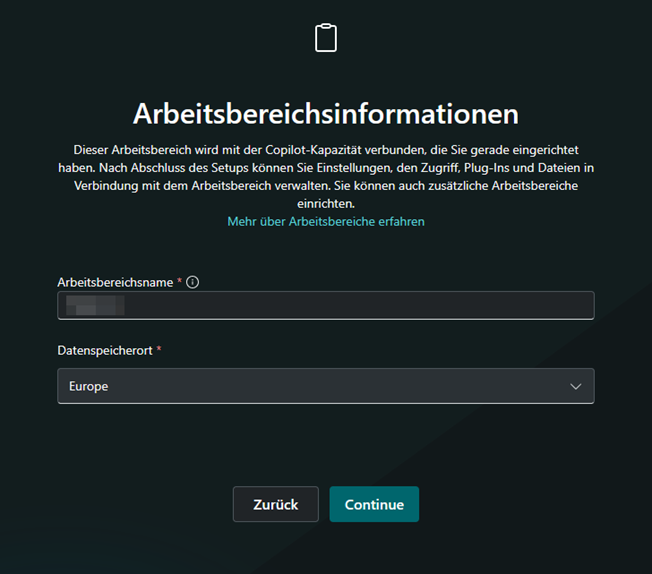

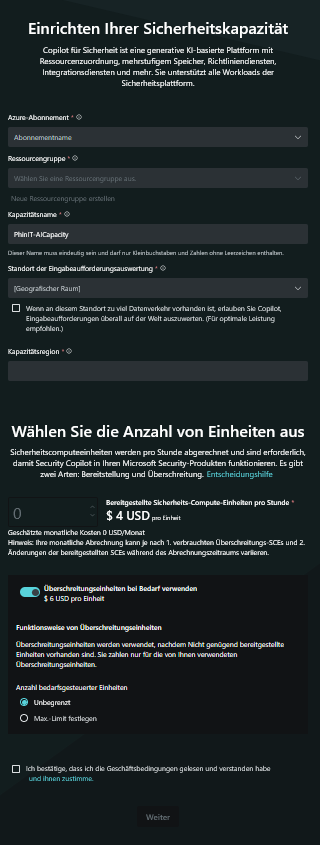

Microsoft Copilot for Sicherheit

Dieses Modul dient als Absprungpunkt für die spezialisierte Sicherheits-KI von Microsoft.

- Getrennte Verwaltung: Es ist wichtig zu beachten, dass die tiefgreifenden Sicherheitskonfigurationen für diesen Dienst nicht direkt im allgemeinen Microsoft 365 Admin Center vorgenommen werden.

- Zentrales Portal: Administratoren müssen direkt zum eigenständigen Portal von Microsoft Copilot for Sicherheit navigieren. Dort werden spezifische Rollen, Zugriffsberechtigungen und die Kapazitätsplanung für die Sicherheitsanalyse gesteuert.

- Kosten: Eine bereitgestellte SCU (Security Compute Unit) kostet ca. 4 USD pro Stunde. Für kurzfristigen Mehrbedarf kannst du zusätzliche Überlast-SCUs zu ca. 6 USD pro Stunde nutzen. Die Verwaltung erfolgt über das Azure-Portal, wo ein Dashboard Nutzung und Kosten transparent anzeigt.

👉 Zur offiziellen Dokumentation: https://securitycopilot.microsoft.com/

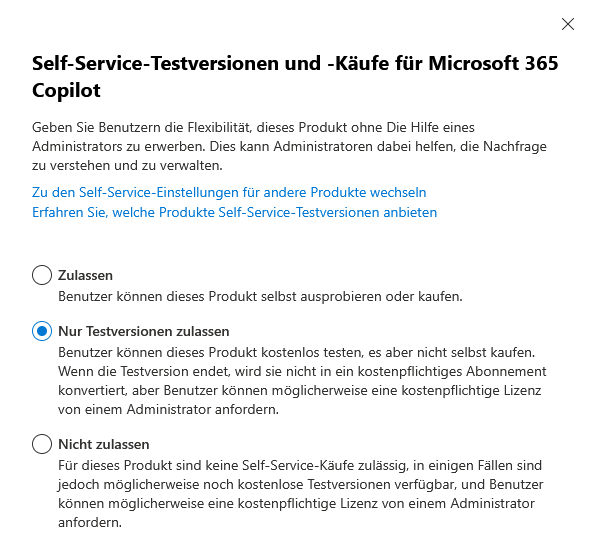

Microsoft 365 Copilot-Self-Service-Käufe

Diese Einstellung regelt das Gleichgewicht zwischen Nutzer-Autonomie und zentraler IT-Governance.

- Kontrollmechanismus: Du entscheidest, ob Endbenutzer die Flexibilität haben sollen, eigenständig Testversionen für Microsoft 365 Copilot zu aktivieren oder das Produkt direkt ohne Administrator-Hilfe zu erwerben.

- Nachfragesteuerung: Diese Option kann Administratoren helfen, die tatsächliche Nachfrage im Unternehmen besser zu verstehen und zu verwalten.

Sicherheits- & Budgetempfehlung: Um unkontrollierte Kosten und den Wildwuchs von Lizenzen zu verhindern, wird empfohlen, Self-Service-Käufe zu deaktivieren. Stattdessen sollte ein interner Genehmigungsprozess etabliert werden.

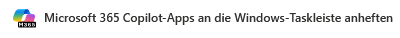

Microsoft 365 Copilot-Apps an die Windows-Taskleiste anheften

Hier wird die Sichtbarkeit der KI-Werkzeuge auf der Betriebssystemebene gesteuert.

- Umfang der Integration: Administratoren können festlegen, ob neben der Hauptanwendung von Microsoft 365 Copilot auch spezialisierte Begleiter-Apps für die Personen, Dateisuche, den Kalender und allgemeine Windows-Funktionen an die Taskleiste angeheftet werden.

- Effizienz: Das Ziel ist es, die KI-basierten Arbeitsweisen leichter auffindbar zu machen und Workflows durch direkten Zugriff zu verbessern.

- Technische Voraussetzung: Diese Richtlinie ist effektiv für Geräte, die via Intune verwaltet werden (Windows 10 und 11) und auf denen die entsprechenden Copilot-Anwendungen bereits installiert sind.

👉 Zur offiziellen Dokumentation: https://go.microsoft.com/fwlink/?linkid=2326492

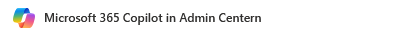

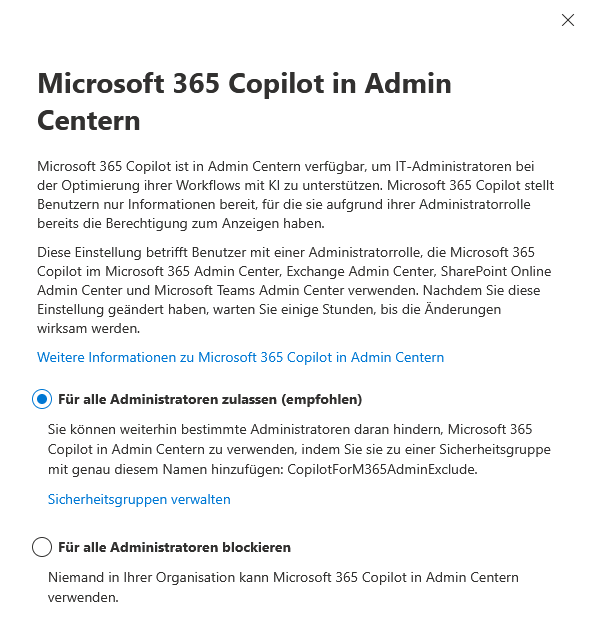

Microsoft 365 Copilot in Admin Centern

Diese Funktion richtet sich speziell an die IT-Administration, um deren Arbeitsalltag durch KI zu unterstützen.

- Unterstützte Konsolen: Copilot ist im Microsoft 365 Admin Center sowie in den Admin Centern für Exchange, SharePoint und Teams verfügbar.

- Datenschutzgarantie: Ein wesentlicher Sicherheitsaspekt ist, dass Copilot den Administratoren ausschließlich Informationen bereitstellt, für die sie aufgrund ihrer bestehenden Administratorrolle bereits eine explizite Berechtigung besitzen.

Gezielter Ausschluss: Organisationen haben die Möglichkeit, den Zugriff für spezifische Administratoren zu sperren. Dies geschieht durch das Hinzufügen der betreffenden Personen zur Sicherheitsgruppe mit dem exakten Namen CopilotForM365AdminExclude.

👉 Zur offiziellen Dokumentation: https://learn.microsoft.com/de-DE/copilot/microsoft-365/copilot-for-microsoft-365-admin

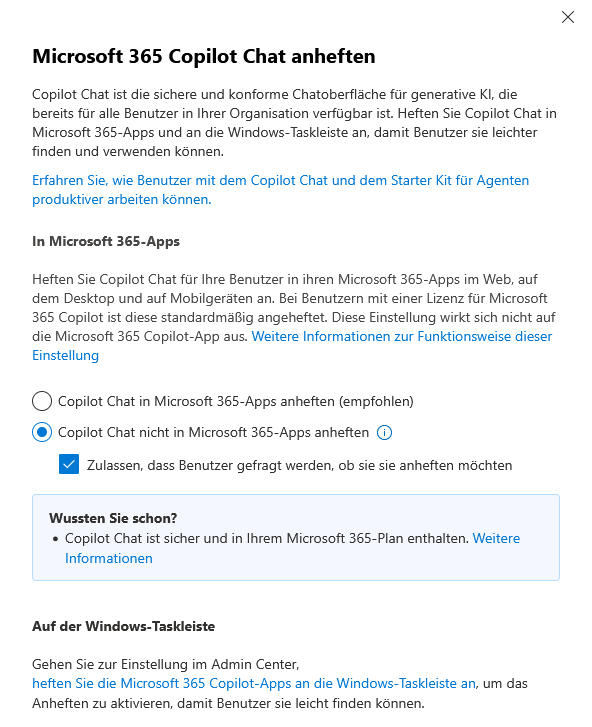

Microsoft 365 Copilot Chat anheften

Dies steuert die Verfügbarkeit der sicheren Chatoberfläche innerhalb der Produktivitätssuite.

- Multi-Plattform-Präsenz: Du kannst konfigurieren, dass Copilot Chat für Benutzer in deren Microsoft 365-Apps (im Web, auf dem Desktop und auf Mobilgeräten) sowie an der Windows-Taskleiste angeheftet wird.

- Lizenz-Logik: Wichtig zu wissen ist, dass Copilot Chat bei Benutzern, die bereits eine gültige Lizenz für Microsoft 365 Copilot besitzen, standardmäßig angeheftet ist.

Abgrenzung: Diese Einstellung wirkt sich ausschließlich auf die Chatoberfläche aus, nicht auf die eigenständige Microsoft 365 Copilot-App.

👉 Zur offiziellen Dokumentation: https://go.microsoft.com/fwlink/?linkid=2282124

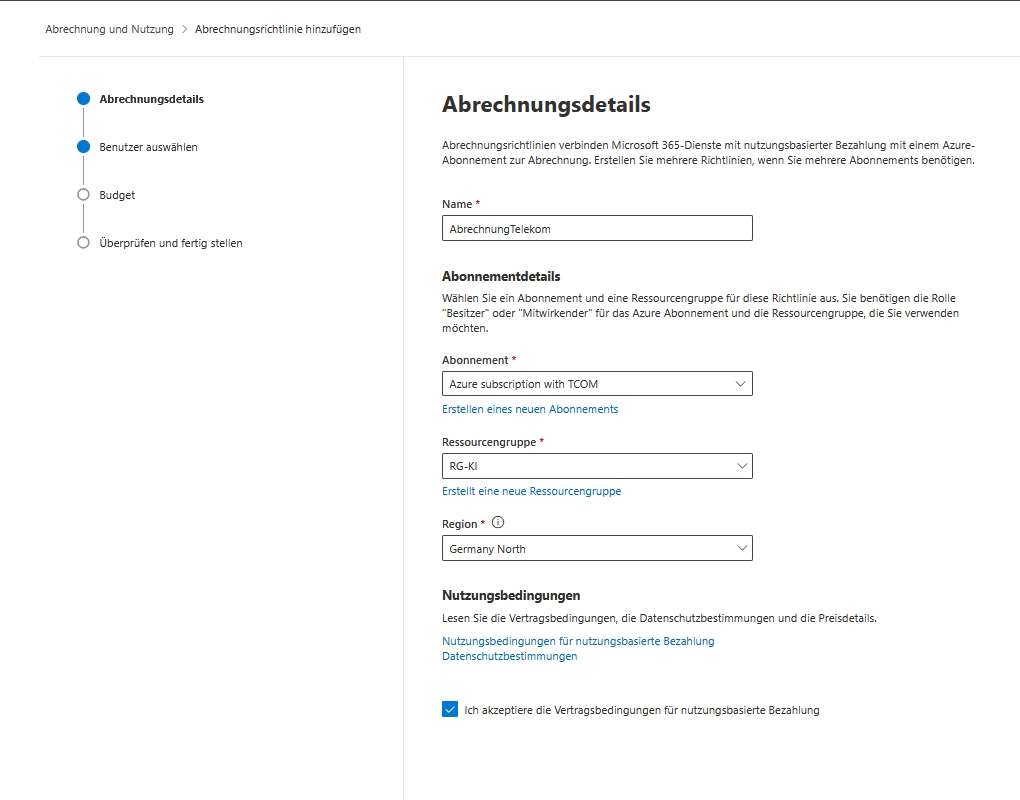

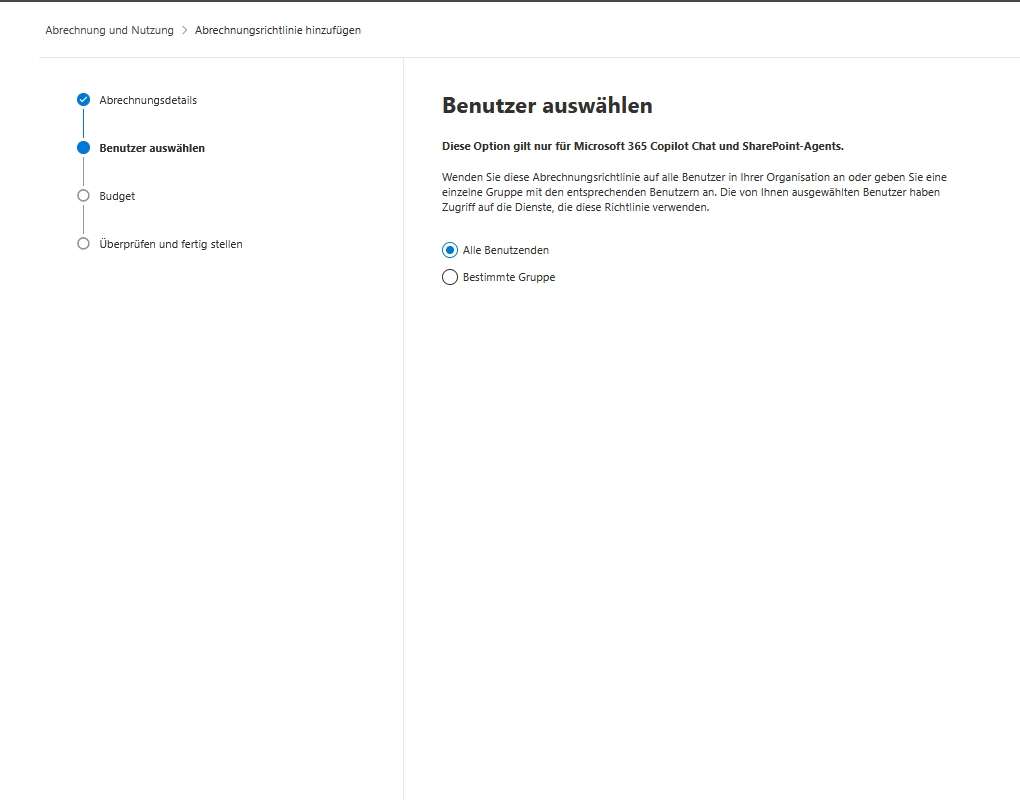

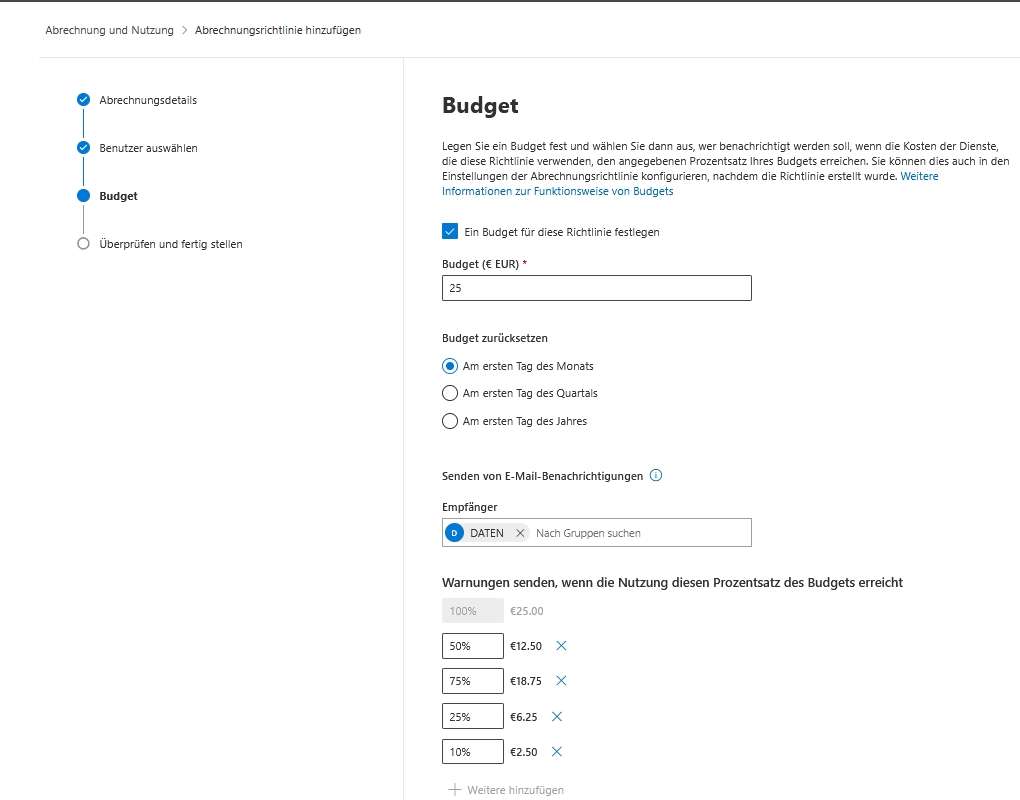

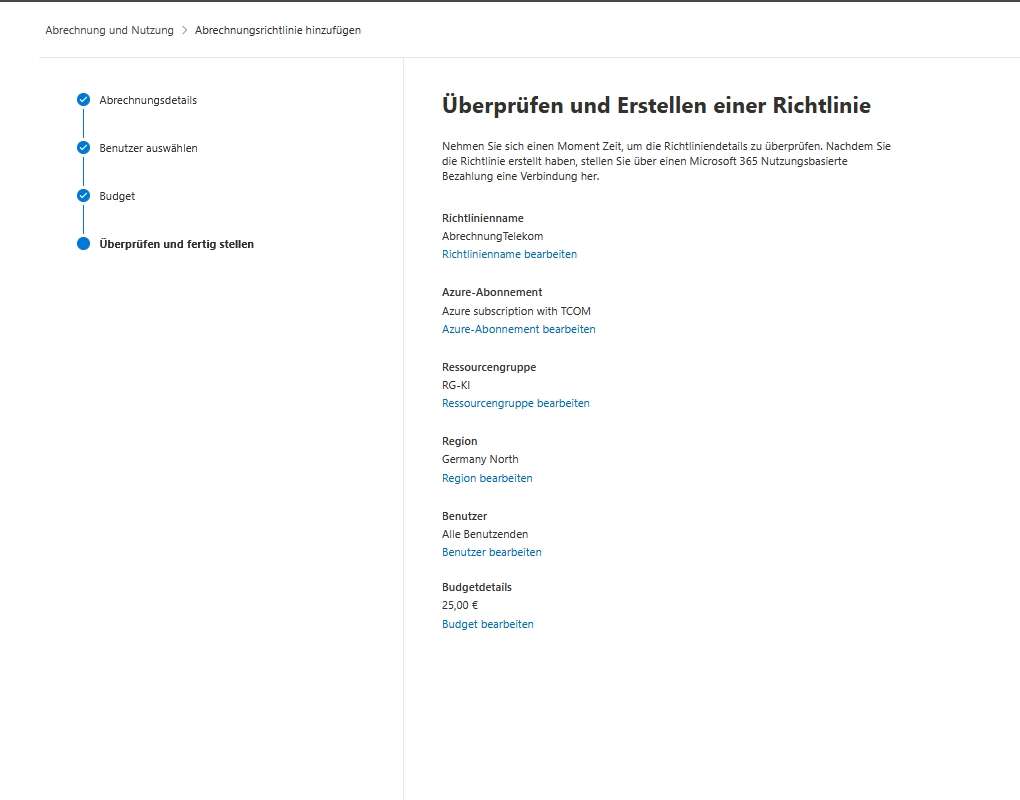

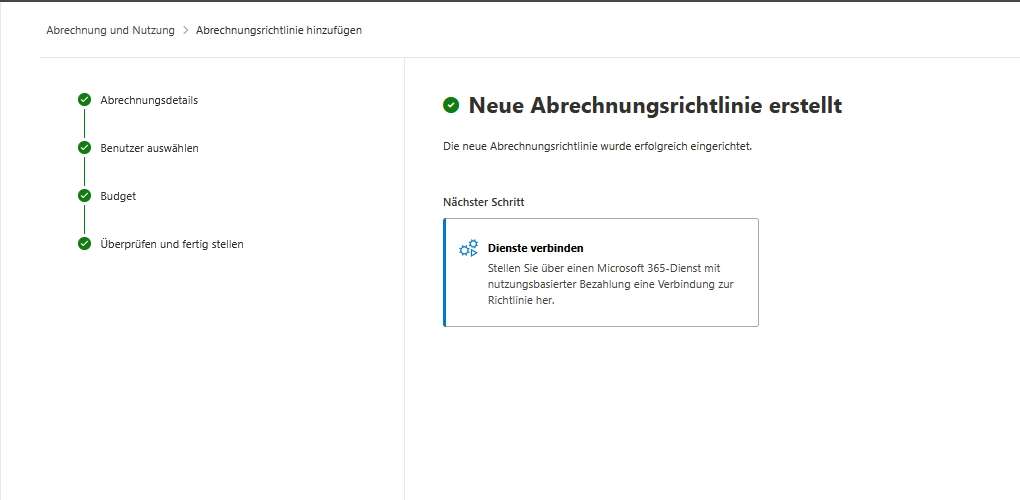

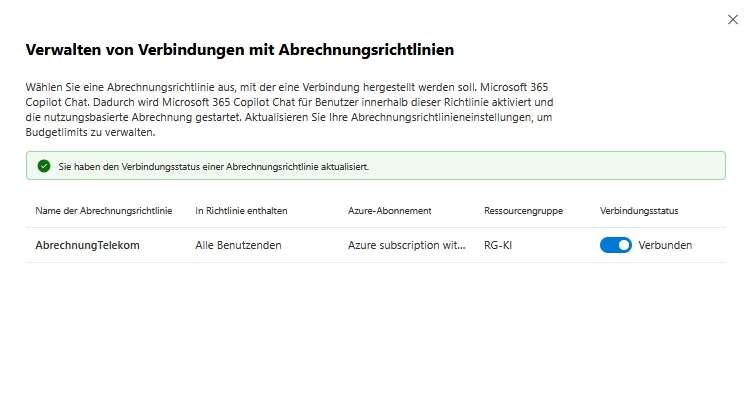

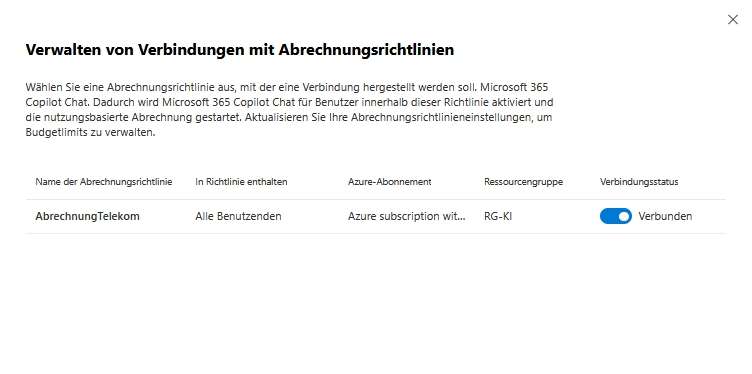

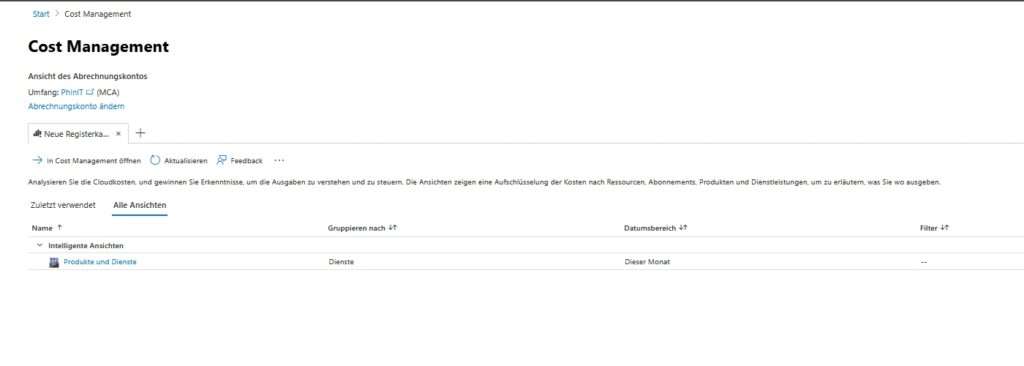

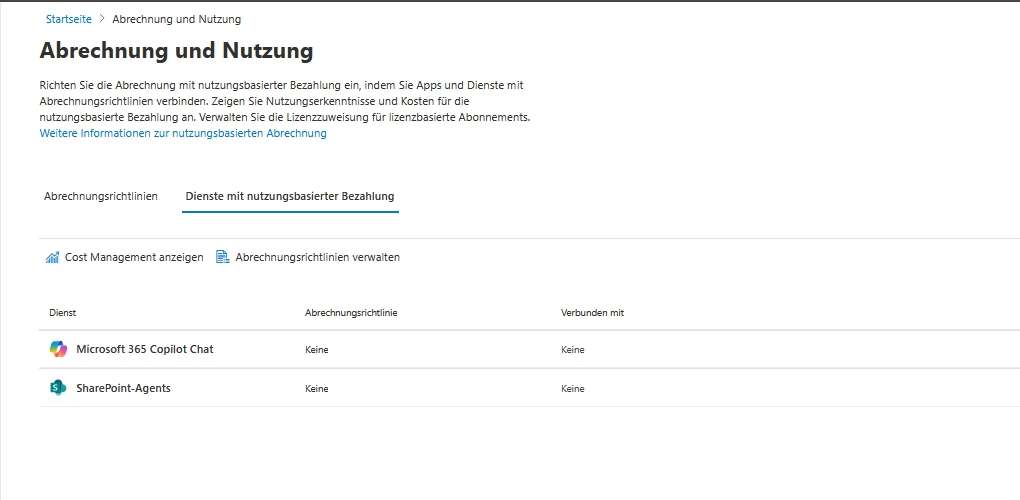

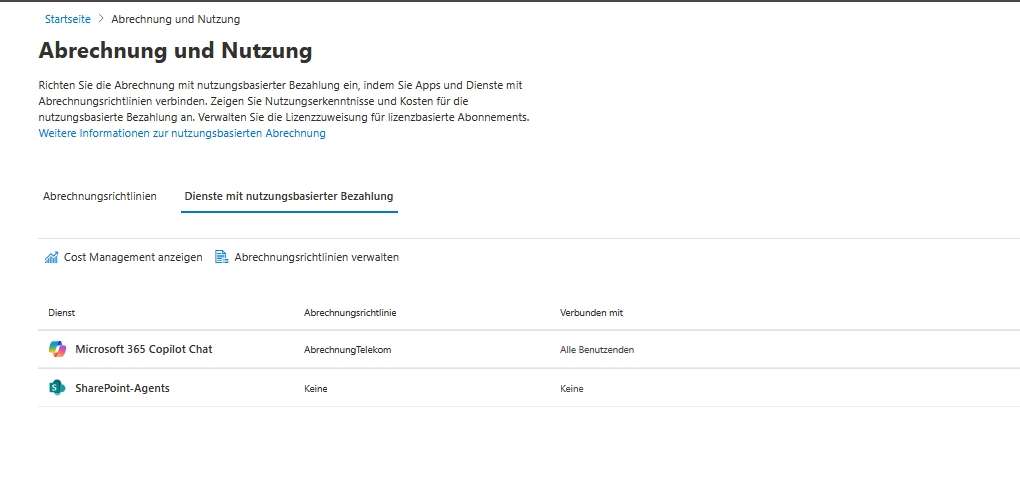

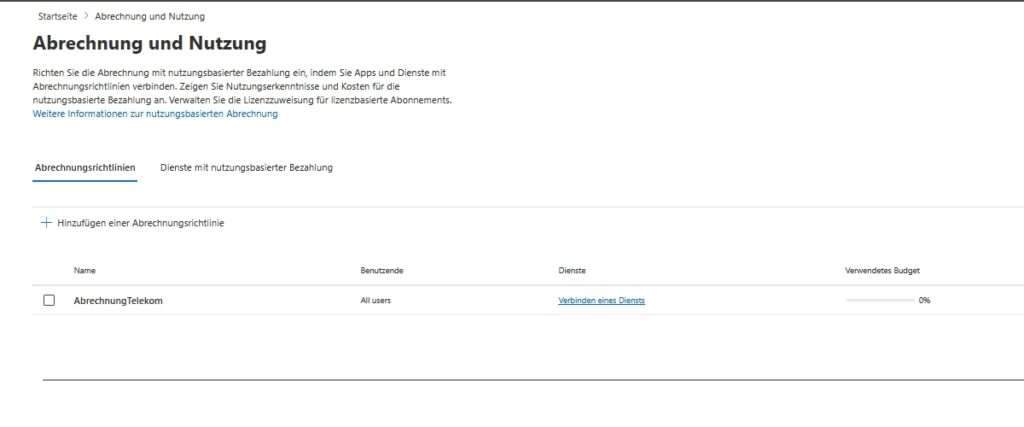

Copilot-Abrechnung mit nutzungsbasierter Bezahlung

Diese Option bietet Administratoren die Möglichkeit, über das klassische Lizenzmodell hinaus spezifische Dienste flexibel abzurechnen.

- Modell: Du richtest hier die nutzungsbasierte Abrechnung (Pay-as-you-go) speziell für Copilot Chat und zugehörige Agents ein.

Kosteneffizienz: Der entscheidende Vorteil liegt darin, dass die Organisation nur für die tatsächliche Nutzung durch die Personen zahlt. Dies verhindert unnötige Fixkosten für Dienste oder Agents, die nur sporadisch oder von wenigen Mitarbeitern verwendet werden.

👉 Zur offiziellen Dokumentation: https://learn.microsoft.com/de-DE/copilot/microsoft-365/pay-as-you-go/overview

Copilot in Edge

Hier wird die tiefe Integration des KI-Assistenten in den Unternehmensbrowser gesteuert.

- Datenschutz-Standard: Copilot in Edge bietet einen KI-basierten Chat, der explizit für die Arbeit konzipiert ist und den Unternehmensdatenschutz gewährleistet.

Erweiterte Konfiguration: Um die KI-Funktionen im Browser granular zu steuern, reicht dieser Schalter allein oft nicht aus. Administratoren müssen zusätzlich ein Konfigurationsprofil im Microsoft Edge-Verwaltungsdienst hinzufügen. Dies ermöglicht eine zentrale Steuerung der Browser-Experience über die gesamte Flotte hinweg.

👉 Zur offiziellen Dokumentation: https://learn.microsoft.com/de-DE/deployedge/microsoft-edge-management-service

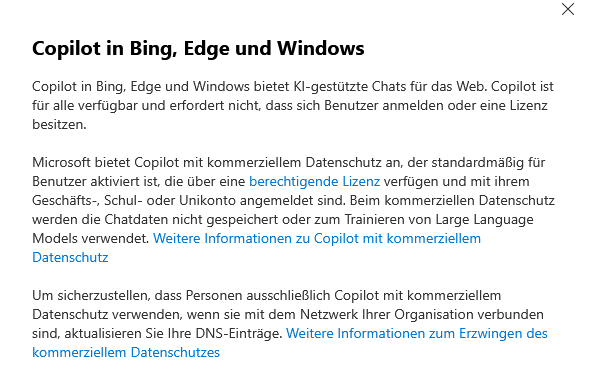

Copilot in Bing, Edge und Windows

Dieser Abschnitt regelt den Zugriff auf die KI-Suche im öffentlichen Web, abgesichert für den geschäftlichen Kontext.

- Funktionsumfang: Hier verwaltest du, wie deine Organisation den KI-basierten Chat in Bing, Edge und Windows verwendet. Dies betrifft in der Regel die webbasierte Recherche.

- Kommerzieller Datenschutz: Microsoft bietet hier standardmäßig den „kommerziellen Datenschutz“ an. Das bedeutet konkret: Wenn Nutzer mit ihrem Geschäfts-, Schul- oder Unikonto angemeldet sind, werden die Chatdaten weder gespeichert noch zum Trainieren der großen Sprachmodelle (LLMs) verwendet.

- Netzwerksicherheit (DNS): Um sicherzustellen, dass Personen im Unternehmensnetzwerk ausschließlich die geschützte Version verwenden (und nicht versehentlich die private Consumer-Version), können Administratoren ihre DNS-Einträge aktualisieren. Dies erzwingt den geschützten Modus auf Netzwerkebene.

- 👉 Zur offiziellen Dokumentation:

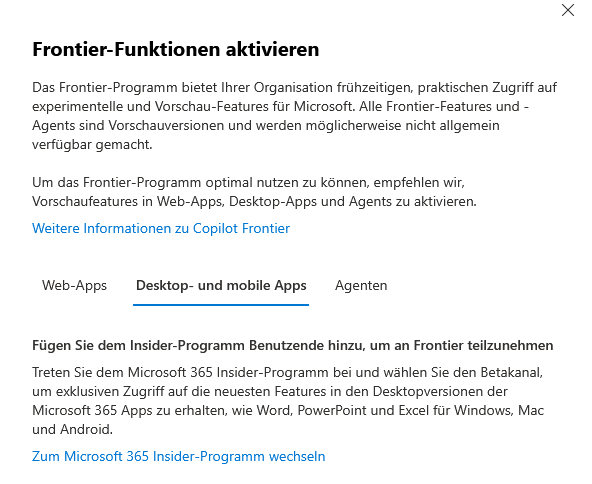

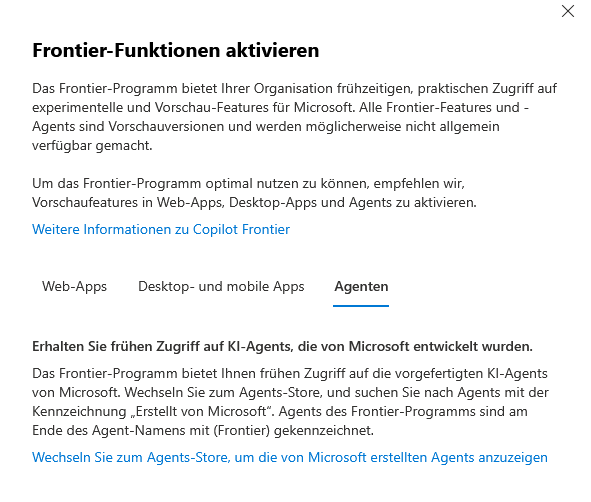

Copilot Frontier

Dies ist das Tor zu den neuesten Innovationen und experimentellen Funktionen von Microsoft.

- Programm-Zugang: Durch die Aktivierung des Early Access Programs (Frontier) erhält deine Organisation exklusiven Zugriff auf experimentelle Features und Vorschau-Agents, die noch nicht allgemein verfügbar sind.

- Ganzheitliche Strategie: Um das Programm optimal zu nutzen, empfiehlt Microsoft, die Vorschaufeatures über alle Kanäle hinweg zu aktivieren: in Web-Apps, Desktop-Apps und für Agents.

Differenzierte Steuerung:

- Web-Apps: Der Zugriff hierfür wird direkt in diesem Menü gesteuert.

- Desktop-Apps: Für Word, Excel & Co. müssen Benutzer zusätzlich dem Microsoft 365 Insider-Programm (Betakanal) beitreten.

- Agents: Der Zugriff auf Frontier-Agents (gekennzeichnet im Store) erfolgt über die Agent-Verwaltungstools.

Weitere Informationen sowie eine Schritt-für-Schritt-Anleitung zur Aktivierung der Frontier-Funktionen finden Sie in den zusätzlichen Ressourcen und der Microsoft Tech Community.

👉 Zur offiziellen Dokumentation: https://adoption.microsoft.com/de-de/copilot/frontier-program/

– Datenzugriff

Dieser Reiter ist die Schaltzentrale für den Informationsfluss. Während du beim „Benutzerzugriff“ steuerst, wer Copilot nutzen darf, definierst du hier, woher Copilot sein Wissen bezieht (Web vs. Intern) und welche KI-Modelle im Hintergrund arbeiten dürfen.

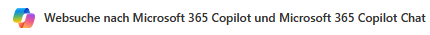

Websuche nach Microsoft 365 Copilot und Microsoft 365 Copilot Chat

Standardmäßig operiert Microsoft 365 Copilot isoliert innerhalb deines Tenants („Grounded in your Graph“). Mit dieser Option öffnest du kontrolliert das Tor zum öffentlichen Internet, um die Wissensbasis der KI massiv zu erweitern.

- Funktionsweise (RAG): Wenn aktiviert, nutzt Copilot Webinhalte, um die Qualität der Antworten zu verbessern. Die KI erkennt, wenn eine interne Datenbasis für eine Antwort nicht ausreicht (z. B. „Wie steht die Microsoft-Aktie heute?“), führt eine anonymisierte Suche via Bing durch und verknüpft diese externen Erkenntnisse mit deinen internen Daten.

- Strategischer Vorteil: Diese Funktion ist unverzichtbar für Abteilungen, die auf Echtzeit-Informationen angewiesen sind (z. B. Marketing, Finance), da der Microsoft Graph keine öffentlichen Dokumentationen, Nachrichten oder aktuelle Marktwerte enthält.

- Granulare Steuerung: Du kannst die Websuche für Microsoft 365 Copilot (in den Apps) und den Copilot Chat getrennt voneinander steuern. Dies ermöglicht dir beispielsweise, die Websuche im Chat zu erlauben, aber in Word/Excel zu deaktivieren, falls dort striktere Content-Regeln gelten sollen.

- Datenschutz: Auch bei aktiver Websuche greifen Schutzmechanismen. Die Suchabfragen werden nicht an Werbetreibende verkauft und nicht von Bing gespeichert, um das Ranking zu beeinflussen.

👉 Zur offiziellen Dokumentation: https://learn.microsoft.com/de-DE/copilot/microsoft-365/manage-public-web-access

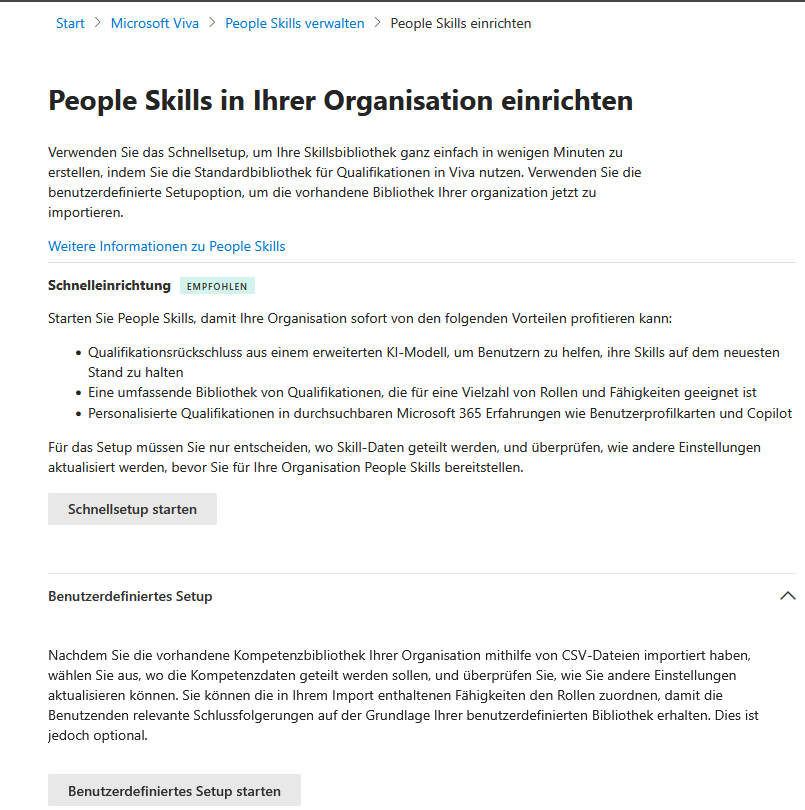

People Skills in Microsoft 365 Copilot

„People Skills“ ist ein KI-gestützter Dienst, der das verborgene Wissen („Tacit Knowledge“) in deiner Organisation sichtbar macht und Silos aufbricht.

- Was es tut (Inferencing): Anstatt auf manuell gepflegte (und oft veraltete) Mitarbeiterprofile zu vertrauen, nutzt der Dienst „Best-in-Class-Inferencing“. Die KI analysiert im Hintergrund, woran Personen arbeiten (Dokumente, E-Mails, Projekte), um daraus abzuleiten, wer welche Fähigkeiten besitzt.

- Mehrwert für die Organisation: Das Tool hilft dabei, Qualifikationslücken proaktiv zu erkennen und interne Weiterbildungen gezielt zu fördern. Es unterstützt Einzelpersonen dabei, ihr Fachwissen sichtbar zu machen und sich mit den richtigen Kollegen zu vernetzen.

- Copilot-Integration: Diese Daten fließen direkt in die generierten Antworten ein. Wenn ein Nutzer fragt: „Wer kennt sich bei uns mit Python-Entwicklung aus?“, greift Copilot auf die People-Skills-Daten zurück, um Experten vorzuschlagen – selbst wenn diese „Python“ nicht explizit in ihrem HR-Profil stehen haben.

👉 Zur offiziellen Dokumentation: https://learn.microsoft.com/de-DE/copilot/microsoft-365/people-skills-overview

KI-Anbieter & Unterauftragsverarbeiter (Wichtig!)

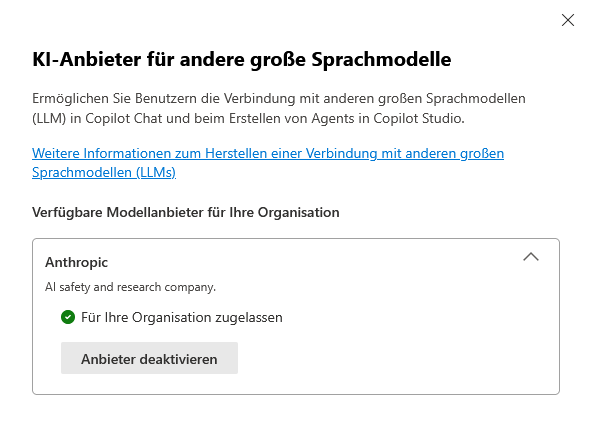

Dieser Bereich markiert einen Paradigmenwechsel: Microsoft öffnet die Plattform für Modelle von Drittanbietern, um spezialisierte KI-Fähigkeiten zu integrieren. Der erste prominente Partner ist Anthropic (Claude Modelle).

- Roadmap: Die Nutzung von Anthropic als offizieller Microsoft-Unterauftragsverarbeiter ist aktuell ab dem 7. Januar 2026 geplant.

- Status Quo: Die Funktion ist standardmäßig deaktiviert, um Administratoren die volle Kontrolle über den Datenfluss zu geben.

- Flexibilität (Andere LLMs): Neben Anthropic kannst du Benutzern grundsätzlich erlauben, sich mit anderen großen Sprachmodellen (LLMs) zu verbinden, sofern dies für spezielle Use-Cases (z. B. Coding, Research) notwendig ist.

⚠️ Kritische Warnung für EU-Kunden: Dies ist der wohl wichtigste Schalter für europäische Datenschutzbeauftragte. Microsoft weist in den Nutzungsbedingungen explizit darauf hin: „Anthropic KI-Modelle […] fallen nicht unter die EU-Datenbegrenzungsverpflichtungen (EU Data Boundary).“

Das bedeutet: Sobald du diese Option aktivierst, verlassen Daten (Prompts und Inhalte), die durch diese Modelle verarbeitet werden, potenziell den gesicherten EU-Rechtsraum. Eine Aktivierung sollte zwingend erst nach Rücksprache mit Legal/Compliance und einer Anpassung des Verzeichnisses von Verarbeitungstätigkeiten erfolgen.

👉 Zur offiziellen Dokumentation: http://go.microsoft.com/fwlink/p/?LinkId=2335702

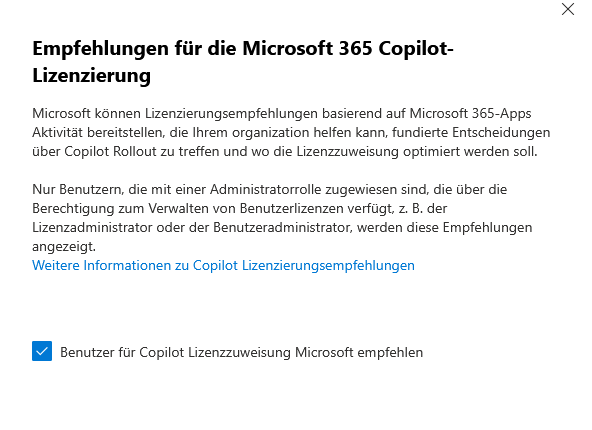

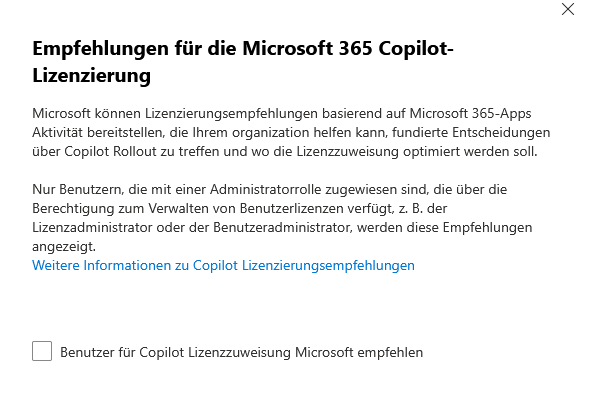

Empfehlungen für die Microsoft 365 Copilot-Lizenzierung

Da Copilot-Lizenzen eine signifikante Investition darstellen, bietet Microsoft hier ein natives FinOps-Feature an, um den ROI (Return on Investment) zu maximieren.

- Funktion: Microsoft analysiert die tatsächliche Nutzung der Microsoft 365-Apps in Relation zur Copilot-Lizenz. Das System erkennt beispielsweise Nutzer, die eine Lizenz haben, aber Copilot-Features nie verwenden, oder Power-User, die noch keine Lizenz besitzen.

- Entscheidungshilfe: Basierend auf diesen Daten erhältst du konkrete Empfehlungen, wo Lizenzen neu zugewiesen („Re-Harvesting“) oder wo das Rollout erweitert werden sollte.

- Sichtbarkeit (RBAC): Aus Datenschutzgründen sind diese sensiblen Nutzungsdaten nicht für jeden Admin sichtbar. Nur Rollen mit expliziter Berechtigung zur Lizenzverwaltung (z. B. Lizenzadministrator oder Benutzeradministrator) können auf diese Empfehlungen zugreifen.

👉 Zur offiziellen Dokumentation: https://go.microsoft.com/fwlink/?linkid=2299550

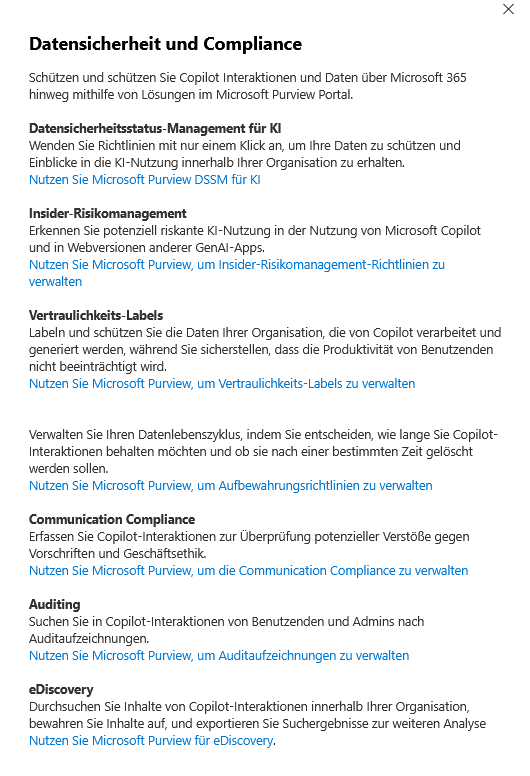

Datensicherheit und Compliance

Dieser Bereich fungiert als strategische Brücke zum Microsoft Purview Portal.

Er erinnert dich daran, dass Copilot kein „rechtsfreier Raum“ ist, sondern denselben strengen Compliance-Regeln unterworfen werden muss wie E-Mails oder Dateien. Hier konfigurierst du die Leitplanken für die KI.

- Datensicherheitsstatus-Management für KI (DSSM): Dies ist oft der beste Startpunkt. Mit nur einem Klick kannst du Basis-Richtlinien anwenden, um deine Daten zu schützen, und erhältst sofortige Einblicke in die KI-Nutzung innerhalb deiner Organisation.

- Insider-Risikomanagement: Hiermit erkennst du potenziell riskantes Verhalten bei der KI-Nutzung – nicht nur in Microsoft Copilot, sondern auch in Webversionen anderer generativer KI-Apps. Das Ziel ist es, kritische Datenabflüsse oder Missbrauch frühzeitig zu identifizieren.

- Vertraulichkeits-Labels (Sensitivity Labels): Dies ist die wichtigste Verteidigungslinie gegen „Over-sharing“. Du labelst und schützt die Daten deiner Organisation, die von Copilot verarbeitet und generiert werden. Copilot respektiert diese Labels: Ein Nutzer ohne Zugriffsberechtigung auf „Streng Vertraulich“-Daten wird auch keine Zusammenfassung dieser Inhalte erhalten.

- Datenlebenszyklus (Data Lifecycle Management): Hier entscheidest du über das digitale Gedächtnis der KI. Verwalte, wie lange Copilot-Interaktionen (Prompts und Antworten) aufbewahrt werden müssen (z. B. aus gesetzlichen Gründen) oder ob sie nach einer bestimmten Zeit automatisch gelöscht werden sollen.

- Communication Compliance: Erfasse und überwache Copilot-Interaktionen, um potenzielle Verstöße gegen interne Vorschriften (z. B. Belästigung, unangemessene Sprache) oder Geschäftsethik zu überprüfen.

- Auditing & eDiscovery: Diese Tools sind essenziell für die Rechtsabteilung. Sie ermöglichen es, in Copilot-Interaktionen von Benutzenden und Administratoren nach Auditaufzeichnungen zu suchen sowie Inhalte im Ernstfall zu bewahren und für Analysen zu exportieren.

Tipp: Die bloße Auflistung im Admin Center reicht nicht. Wie du eine dieser Sicherheitsfunktionen konkret einrichtest, liest du in unserem separaten Artikel

👉 Microsoft Purview | DLP – Copilot Prompts (SITs) effektiv absichern!

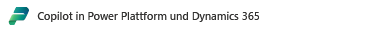

Copilot in Power Plattform und Dynamics 365

Copilot ist tief in die Business-Applikationen integriert. Die Einstellungen in diesem Tab sind jedoch nur Verweise.

- Verwaltungsort: Für spezifische Einstellungen zu Microsoft Copilot, Agents und Copilot Agents in Power Platform und Dynamics 365 Produkten musst du in das Power Platform Admin Center wechseln.

- Relevanz: Dies betrifft vor allem Low-Code-Entwicklungen und CRM-Prozesse, wo Copilot oft direkten Zugriff auf Kundendatenbanken hat.

👉 Zur offiziellen Dokumentation: https://go.microsoft.com/fwlink/?linkid=2297186

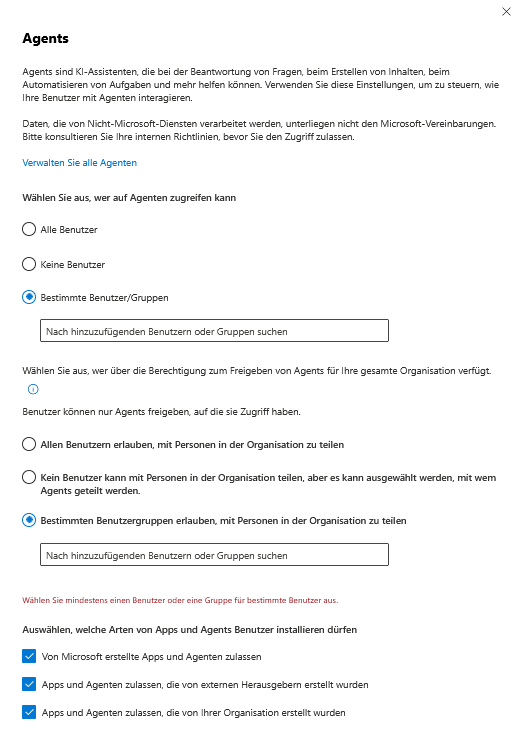

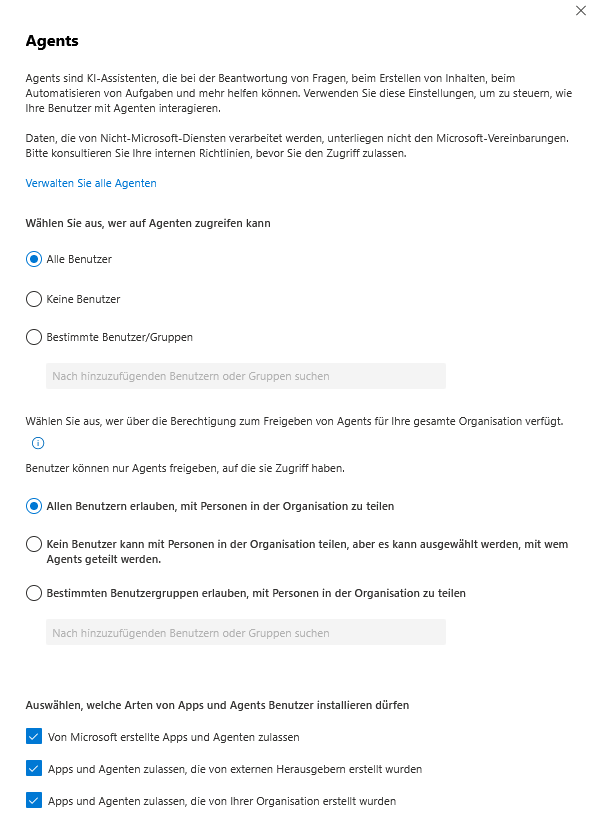

Agents

Agents sind spezialisierte KI-Assistenten, die weit mehr können als nur chatten: Sie helfen bei der Beantwortung von Fragen, erstellen Inhalte und automatisieren komplexe Aufgaben. Da sie oft tief in Prozesse eingreifen, ist hier eine strikte Governance erforderlich.

- Compliance-Warnung: Sei dir bewusst, dass Daten, die von Nicht-Microsoft-Diensten (Drittanbieter-Agents) verarbeitet werden, nicht den Microsoft-Vereinbarungen unterliegen. Es gelten die AGB und Datenschutzbestimmungen des jeweiligen Herstellers. Konsultiere zwingend deine internen Richtlinien, bevor du den Zugriff zulässt.

- Zugriffssteuerung:

- Zugriff: Wähle granular aus, wer in deiner Organisation überhaupt auf Agents zugreifen darf.

- Installation: Definiere, welche Arten von Apps und Agents Benutzer eigenständig installieren dürfen, um einen Wildwuchs an ungeprüfter Software zu verhindern.

- Sharing (Verbreitung): Steuere präzise, wer Agents mit der gesamten Organisation teilen darf.

Hinweis: Benutzer, denen das weite Teilen untersagt ist, können ihre Agents weiterhin mit einzelnen Kollegen oder Sicherheitsgruppen teilen, was die Kollaboration im kleinen Rahmen erhält, ohne den gesamten Tenant zu fluten.

👉 Zur offiziellen Dokumentation: https://admin.cloud.microsoft/#/copilot/agents

– Copilot-Aktionen

Im Reiter Copilot-Aktionen verlässt du die Ebene der reinen Datenfreigabe und definierst das konkrete Verhalten der KI. Hier geht es nicht mehr nur darum, worauf Copilot zugreifen darf, sondern was er aktiv generieren soll und wie transparent er dabei gegenüber deinen Nutzern auftritt.

Vom verpflichtenden Haftungsausschluss über die Freigabe kreativer Features (Bild- & Videogenerierung) bis hin zur sensiblen Steuerung in Teams-Meetings: In diesem Bereich konfigurierst du die Balance zwischen einer modernen User Experience und den notwendigen Compliance-Leitplanken deines Unternehmens.

KI-Haftungsausschluss für Copilot

Transparenz ist der entscheidende Faktor bei der Einführung generativer KI. Nutzer müssen verstehen, dass KI-Antworten Fehler (Halluzinationen) enthalten können. Hier konfigurierst du die Sichtbarkeit dieser Warnhinweise.

- Sichtbarkeit erhöhen: Du kannst die Schriftbreite des Standard-Haftungsausschlusses in der Microsoft 365 Copilot-App vergrößern. Dies verhindert, dass der Hinweis im Arbeitsalltag als „Kleingedrucktes“ übersehen wird.

- Anpassbare QuickInfo: Füge eine QuickInfo mit einem benutzerdefinierten Link („Weitere Informationen“) hinzu.

- Best Practice: Verlinke hier auf deine internen KI-Richtlinien oder eine Intranet-Seite, die den Mitarbeitenden erklärt, wie sie Ergebnisse verifizieren müssen und welche Datenklassifizierungen gelten.

- Vorschau-Modus: Nutze die Funktion „Haftungsausschluss in der Vorschau anzeigen“, um vor dem Speichern zu simulieren, wie die Warnung für deine Endanwender in der App tatsächlich aussieht.

👉 Zur offiziellen Dokumentation: https://learn.microsoft.com/de-DE/copilot/microsoft-365/microsoft-365-ai-disclaimers

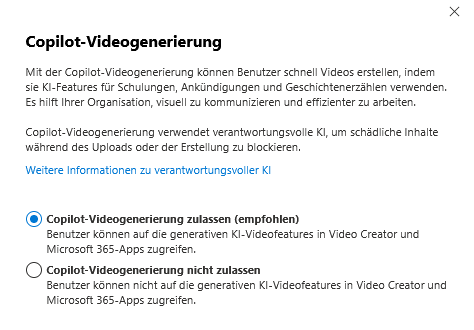

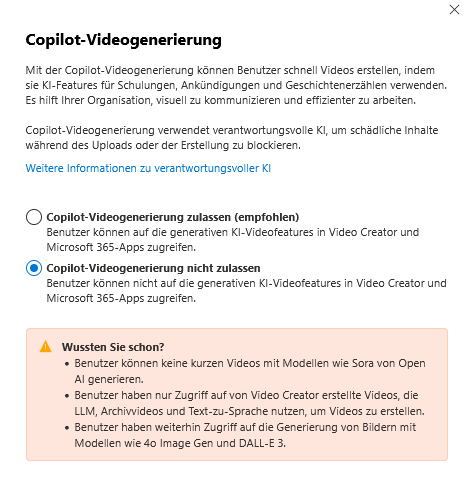

Copilot-Videogenerierung

Mit dieser Funktion verwandelst du Textprompts in bewegte Bilder. Dies demokratisiert die Videoerstellung im Unternehmen.

- Einsatzszenarien: Benutzer können schnell Videos für Schulungen, interne Ankündigungen oder Storytelling erstellen. Dies hilft Abteilungen wie HR oder Kommunikation, visuell ansprechende Inhalte zu produzieren, ohne auf teure externe Agenturen angewiesen zu sein.

- Verantwortungsvolle KI (Sicherheit): Administratoren, die Sorge vor Missbrauch haben, können beruhigt sein: Der Dienst nutzt Filter für verantwortungsvolle KI. Diese blockieren proaktiv schädliche Inhalte bereits während des Uploads von Quellmaterial oder während des Generierungsprozesses.

- Produktivität: Das Ziel ist es, effizienter zu arbeiten und komplexe Sachverhalte visuell verständlich zu machen.

👉 Zur offiziellen Dokumentation: https://www.microsoft.com/de-DE/ai/principles-and-approach

Copilot-Bildgenerierung

Hierbei handelt es sich um die Integration von bildgebender KI (basierend auf DALL-E Technologie) direkt in die Office-Workflows.

- Kreative Assistenz: Benutzer können Copilot bitten, Bilder zu erstellen, zu entwerfen und zu bearbeiten. Dies dient dazu, Ideen in PowerPoint oder Word sofort zu visualisieren, anstatt stundenlang in Stock-Foto-Datenbanken zu suchen.

- Inhaltsmoderation: Wie bei der Videoerstellung greift auch hier der Schutz durch verantwortungsvolle KI. Das System verhindert technisch das Hochladen oder Generieren von schädlichen, anstößigen oder gewaltverherrlichenden Bildern. Dies sichert die Brand Safety deines Unternehmens.

👉 Zur offiziellen Dokumentation: https://learn.microsoft.com/copilot/microsoft-365/microsoft-365-copilot-page#copilot-image-generation

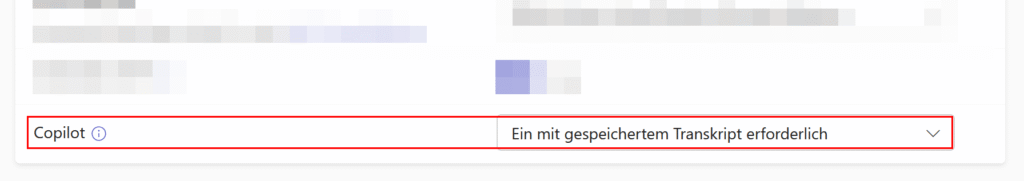

Copilot in Teams-Besprechungen

Diese Einstellung ist oft der kritischste Punkt in Diskussionen mit dem Betriebsrat oder Datenschutzbeauftragten. Du steuerst hier, ob und wie Copilot Gespräche analysieren darf.

Es gibt drei wesentliche Konfigurationsstufen:

Vor, während und nach der Besprechung (Standard):

- Funktion: Dies erfordert meist eine aktive Transkription. Copilot kann das gesamte Meeting analysieren und liefert danach eine Zusammenfassung („Intelligent Recap“).

- Vorteil: Maximale Produktivität und Nachvollziehbarkeit.

- Nachteil: Es entsteht ein dauerhaftes Transkript der Sitzung.

Nur während einer Besprechung (Datenschutz-Modus):

- Funktion: Copilot analysiert das Gespräch flüchtig in Echtzeit, um Fragen zu beantworten.

- Datenschutz: Es werden keine Daten gespeichert. Sobald das Meeting endet, „vergisst“ die KI den Inhalt. Es gibt kein Transkript und keine Zusammenfassung im Nachhinein.

Überhaupt nicht: Copilot wird für Meetings komplett deaktiviert.

- Lizenz-Check: Beachte, dass Copilot für Personen, die keine Lizenz besitzen, in Besprechungen immer deaktiviert ist, selbst wenn der Organisator eine Lizenz hat.

👉 Zur offiziellen Dokumentation: https://go.microsoft.com/fwlink/?linkid=2265021

– Andere Einstellungen

Der Tab Andere Einstellungen bündelt administrative Funktionen, die nicht direkt den Zugriff oder den Datenfluss steuern, sondern den operativen Betrieb und die Qualitätssicherung betreffen. Hier findest du Werkzeuge für den Support-Fall und zur Anpassung der Spracherkennung.

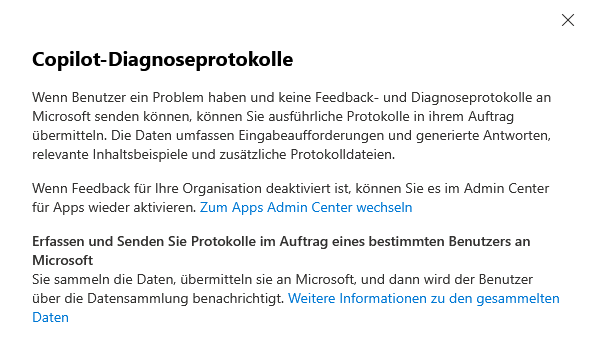

Copilot-Diagnoseprotokolle

Gilt für „Microsoft 365 Copilot“

Wenn es mal klemmt, ist dies dein wichtigstes Werkzeug für den Second-Level-Support.

- Support im Auftrag des Benutzers: Wenn Benutzer technische Probleme haben, aber selbst keine Feedback- oder Diagnoseprotokolle an Microsoft senden können (z. B. aufgrund technischer Hürden oder restriktiver Client-Richtlinien), kannst du als Administrator einspringen.

- Umfang der Daten: Du kannst ausführliche Protokolle im Namen des betroffenen Nutzers erfassen und übermitteln. Beachte, dass diese Daten sehr sensibel sind: Sie umfassen die konkreten Eingabeaufforderungen (Prompts), die generierten Antworten sowie relevante Inhaltsbeispiele und Systemprotokolle.

- Transparenz: Der Datenschutz wird gewahrt, indem der Benutzer automatisch über die Datensammlung benachrichtigt wird, sobald du die Protokolle übermittelst.

- Voraussetzung: Sollte die Feedback-Funktion generell in deiner Organisation deaktiviert sein, musst du sie zuerst im Apps Admin Center reaktivieren, um dieses Feature nutzen zu können.

👉 Zur offiziellen Dokumentation: https://go.microsoft.com/fwlink/?linkid=2250136

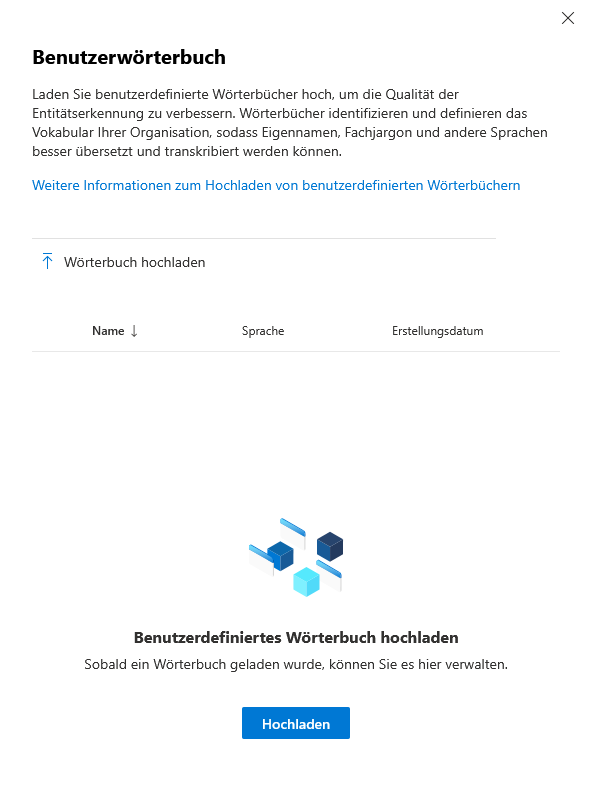

Copilot-Benutzerwörterbuch

Gilt für „Copilot in Microsoft Teams & Microsoft Teams“

Copilot ist schlau, kennt aber nicht jeden internen Fachjargon. Hier hilfst du der KI auf die Sprünge.

- Qualitätssteigerung: Lade benutzerdefinierte Wörterbücher hoch, um die Entitätserkennung in Microsoft Teams signifikant zu verbessern.

- Funktion: Diese Wörterbücher definieren das spezifische Vokabular deiner Organisation. Das sorgt dafür, dass Eigennamen, Produktbezeichnungen, branchenspezifischer Fachjargon oder interne Abkürzungen korrekt transkribiert und übersetzt werden, anstatt phonetisch falsch interpretiert zu werden.

- Konsistenz: Durch die zentrale Verwaltung im Admin Center stellst du sicher, dass alle Teams-Räume und Anwendungen auf denselben Wortschatz zugreifen. Das Ergebnis sind präzisere Meeting-Protokolle und Zusammenfassungen, die deine internen Projektnamen korrekt wiedergeben.

👉 Zur offiziellen Dokumentation: https://aka.ms/learncustomdictionary

Der Faktor Mensch & Recht

Nachdem wir die technischen Schalter im Admin Center justiert haben, müssen wir den Blick weiten. Eine erfolgreiche Copilot-Einführung steht und fällt mit der Transparenz gegenüber der Belegschaft und dem Bewusstsein für neue Sicherheitsrisiken.

1. Transparenz & DSGVO-Konformität | Technisch kannst du Copilot aktivieren, aber rechtlich musst du deine Mitarbeitenden mitnehmen.

- Informationspflicht (Art. 13 DSGVO): Informiere alle Betroffenen proaktiv über den Einsatz der KI. Kläre darüber auf, wie Prompts verarbeitet werden, wie lange sie gespeichert werden und welche Zwecke die Datenverarbeitung verfolgt.

- Betriebsrat: Die Möglichkeiten zur Leistungsüberwachung (z. B. über das Admin-Feedback oder Logs) machen Copilot oft mitbestimmungspflichtig. Dokumentiere klar, welche Auswertungen technisch möglich sind und welche nicht durchgeführt werden (Selbstverpflichtung).

2. Datenhoheit für Endanwender (My Account) | Datenschutz ist keine Einbahnstraße. Gib deinen Nutzern Werkzeuge an die Hand, um ihre eigene Privatsphäre zu wahren.

- Selbstverwaltung: Zeige deinen Mitarbeitenden das „My Account“-Portal. Dort können sie ihren eigenen Copilot-Aktivitätsverlauf einsehen und gespeicherte Prompts sowie Antworten eigenständig löschen.

- Vertrauen: Das Wissen, dass man den eigenen Chatverlauf bereinigen kann, erhöht die Akzeptanz der KI-Tools massiv.

3. Schutz vor Prompt-Injection & Awareness | Copilot bringt neue Angriffsvektoren mit sich, die eine klassische Firewall nicht abfängt.

- Die Gefahr: Bei „Prompt-Injection“-Angriffen versuchen Dritte, die Sicherheitsfilter der KI durch manipulative Eingaben zu umgehen. Microsoft integriert zwar technische „Jailbreak“-Filter, doch diese sind kein Allheilmittel.

- Der menschliche Schutzwall: Technische Filter müssen durch organisatorische Maßnahmen ergänzt werden.

- Schulung: Sensibilisiere Nutzer regelmäßig, niemals Passwörter oder hochkritische Geheimnisse (z. B. Private Keys) in Prompts einzugeben.

- Kritischer Umgang: Inhalte aus externen Quellen (z. B. eine zusammengefasste Phishing-Mail oder eine manipulierte Website) können die KI austricksen. Nutzer müssen lernen, KI-Ergebnisse stets zu verifizieren.

4. Das Sicherheitsnetz: Purview & DLP | Wie bereits im Abschnitt „Datenzugriff“ erwähnt, ist Microsoft Purview deine Lebensversicherung gegen Datenabfluss.

- Automatisierter Schutz: Nutze Sensitivity Labels und DLP-Richtlinien, um sicherzustellen, dass vertrauliche Daten (HR-Akten, Patente) technisch gar nicht erst von Copilot verarbeitet oder ausgegeben werden dürfen.

- Speicherung: Behalte im Hinterkopf, dass Copilot-Daten in speziellen, verborgenen Exchange-Ordnern liegen. Deine Retention Policies (Aufbewahrungsrichtlinien) müssen explizit prüfen, ob diese KI-Daten genauso lange gespeichert werden sollen wie normale E-Mails oder Chats.

Hinterlasse jetzt einen Kommentar